A principios de este año, el Departamento de Educación de Australia del Sur decidió llevar la IA generativa a sus aulas. Pero antes de abrir las puertas, una pregunta surgió: ¿cómo hacerlo de manera responsable?

La principal preocupación giraba en torno a ayudar a proteger a los estudiantes de contenidos potencialmente dañinos o inapropiados que pueden reflejarse en el resultado de un gran modelo de lenguaje, dada su formación en vastas extensiones sin filtrar de Internet, dijo Simon Chapman, director de arquitectura digital del departamento.

«Lo que está disponible en las versiones públicas de IA generativa es bastante limitado para la educación», afirmó. «No existen barreras de seguridad sobre cómo los estudiantes pueden interactuar con él».

Un avance rápido hasta el día de hoy, y el departamento está por concluir una prueba piloto de EdChat, un chatbot impulsado por inteligencia artificial. Casi 1,500 estudiantes y 150 profesores de ocho escuelas secundarias probaron la capacidad del bot para ayudar a investigar todo, desde la división celular hasta la trama de «De ratones y hombres» de John Steinbeck.

El departamento todavía está en el proceso de evaluación de los resultados, dijo Chapman. Pero el sistema de Microsoft que utilizó como barrera recibió altas calificaciones: Azure AI Content Safety, una plataforma impulsada por IA para ayudar a las organizaciones a crear entornos en línea más seguros.

Las funciones de seguridad integradas de EdChat bloquearon consultas de entrada inapropiadas y filtraron respuestas dañinas, lo que permitió a los maestros centrarse en los beneficios educativos de la tecnología en lugar de la supervisión del contenido, dijo.

«No hubiéramos podido avanzar a este ritmo sin contar con el servicio de seguridad de contenido desde el día 1», dijo Chapman. «Es imprescindible».

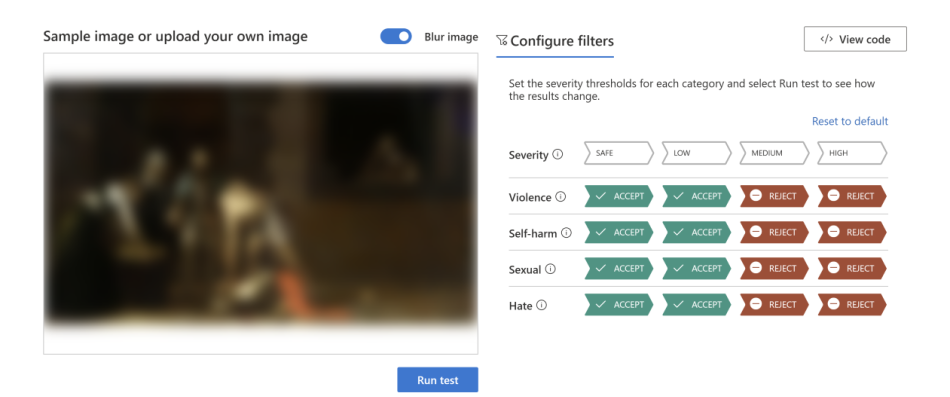

Microsoft anunció hoy la disponibilidad general de Azure AI Content Safety dentro de la plataforma Azure AI, que utiliza lenguaje avanzado y modelos de visión para ayudar a detectar contenido de odio, violencia, sexual y autolesión. Cuando los modelos detectan contenido en potencia dañino, lo marcan con una puntuación de gravedad estimada. Eso permite a las empresas y organizaciones personalizar el servicio para bloquear o marcar contenido según sus políticas.

Introducido en un principio como parte del servicio Azure OpenAI, Azure AI Content Safety ahora es un sistema independiente. Eso significa que los clientes pueden usarlo para contenido generado por IA a partir de modelos de código abierto y modelos de otras compañías, así como para contenido generado por usuarios como parte de sus sistemas de contenido, ampliando su utilidad, dijo Microsoft.

A medida que la IA generativa se vuelve más popular, Microsoft apunta a equipar a las empresas con las herramientas necesarias para implementarla de manera más segura, dijo Eric Boyd, vicepresidente corporativo de Microsoft AI Platform.

«Estamos en un momento bastante sorprendente en el que las empresas comienzan a ver el increíble poder de la IA generativa», dijo Boyd. «Lanzar Azure AI Content Safety como un producto independiente significa que podemos atender a una gran cantidad de clientes con una gama mucho más amplia de necesidades comerciales».

Es solo un ejemplo de cómo Microsoft ha puesto en práctica sus principios para crear IA de manera responsable. La empresa cuenta con casi 350 personas que trabajan en una IA responsable. En los últimos años, Microsoft ha abogado por una gobernanza de la IA responsable y ha apoyado los compromisos voluntarios de IA de la Casa Blanca de Estados Unidos; traspasó los límites de la investigación de la IA responsable para informar el desarrollo de productos; lanzó un Estándar de IA Responsable para diseñar, construir y probar sistemas de IA; y poner herramientas como el Responsible AI Dashboard de Azure Machine Learning en manos de los clientes.

“Esto no es una ocurrencia tardía, sino una parte clave de nuestra historia de innovación en IA. Brindamos las mejores herramientas para descubrir cómo resolver estos desafíos de la IA responsable”, dijo Sarah Bird, gerente de productos del grupo de socios de Microsoft que lidera la IA responsable para tecnologías fundamentales. «Azure AI Content Safety ha sido una pieza fundamental que nos permite enviar nuestras aplicaciones de IA generativa a más clientes».

Personalizable para diferentes casos de uso

A nivel interno, Microsoft ha confiado en Azure AI Content Safety para ayudar a proteger a los usuarios de sus propios productos impulsados por IA. La tecnología fue esencial para lanzar de manera responsable innovaciones basadas en chat en productos como Bing, GitHub Copilot, Microsoft 365 Copilot y Azure Machine Learning, dijo Bird.

En un mundo inundado de contenido, los problemas de la IA responsable afectan a empresas e industrias. Es por eso que una ventaja clave de Azure AI Content Safety es su capacidad de configuración, dijo Bird. Las políticas se pueden ajustar para adaptarse al entorno y los casos de uso específicos de cada cliente. Una plataforma centrada en los juegos, por ejemplo, es probable que establezca estándares diferentes para cosas como el lenguaje violento en comparación con una plataforma para la educación en el aula.

Por ejemplo, la empresa de energía Shell desarrolló una plataforma de inteligencia artificial generativa, Shell E. La plataforma permite a los equipos crear e implementar aplicaciones basadas en código abierto y otros grandes modelos de lenguaje, que permiten a los empleados hacer preguntas y recuperar información para complementar sus flujos de trabajo.

Shell E tiene como objetivo ayudar a los trabajadores a acceder y utilizar el conocimiento de la empresa de manera más eficiente, dijo Siva Chamarti, gerente técnico senior de Sistemas de IA en Shell. Los casos de uso cubren todas las áreas de Shell e incluyen redacción, resumen y traducción de contenido; generación y prueba de código; y gestión del conocimiento en todas las áreas técnicas. Los equipos también exploran casos de uso más complejos, como la generación molecular.

Azure AI Content Safety juega un papel fundamental en la gobernanza de la plataforma Shell E al permitir la generación de texto e imágenes y al mismo tiempo restringir respuestas inapropiadas o dañinas, dijo. La herramienta verifica que cada entrada y salida cumpla con las políticas antes de permitir que el contenido generado llegue a los usuarios.

«Vemos un gran entusiasmo por la IA generativa», dijo Chamarti. «Aún es pronto, pero los colegas han comenzado a idear usos creativos para su propio trabajo y nuestra acumulación de casos de uso es cada vez más larga».

Construir confianza en la era de la IA

A medida que la IA generativa mantenga su proliferación, también lo harán las amenazas potenciales a los espacios en línea.

Para mantenerse a la vanguardia de esas amenazas, Microsoft mejorará de manera continua la tecnología a través de investigaciones y comentarios de los clientes, dijo Bird. Por ejemplo, el trabajo en curso sobre modelos multimodales fortalecerá la detección de combinaciones potencialmente objetables de imágenes y texto (pensemos en memes) que pueden pasar desapercibidas en las comprobaciones individuales.

Boyd señaló que Microsoft se ha ocupado de la moderación de contenido durante décadas, donde ha creado herramientas que ayudaron a proteger a los usuarios en todas partes, desde los foros de Xbox hasta Bing. Azure AI Content Safety se basa en esa experiencia (y en Azure Content Moderator, el servicio anterior que permitía a los clientes aprovechar el poder de las capacidades de detección de contenido) y aprovecha nuevos y potentes modelos de lenguaje y visión.

Al pensar de manera integral sobre la seguridad, Microsoft espera permitir una adopción amplia de la IA en la que los consumidores puedan confiar.

«La confianza es algo que ha sido la piedra angular de la marca Microsoft y de Azure desde el principio», dijo Boyd. «A medida que avanzamos hacia esta era de la IA, continuamos con la ampliación de la forma en que nos aseguramos de proteger a nuestros clientes».

Contenido relacionado:

Comentarios

Publicar un comentario